Weltweit gibt es 2,6 Milliarden aktive YouTube Nutzer*innen – so die Muttergesellschaft Google. Bei einer derart von Social Media dominierten Gesellschaft entstehen Schattenseiten – zum Beispiel, wenn Kinder online gewaltvollen Inhalten begegnen.

Ein kurzer Exkurs: Als ich vergangenes Weihnachten in den USA war, konnte ich in Restaurants Familien beim Essen beobachten. Hierzu muss man wissen, dass bei den meisten Restaurants Tablets an den Tischen befestigt sind – um darüber zu bezahlen, die mobilen Endgeräte sind aber auch mit Spielen wie “Plants vs. Zombies” oder “Z-Trivia”, aber auch mit Disney-Inhalten für Kinder ausgestattet. Was sich dementsprechend oft beobachten lässt: die Eltern essen und die Kinder hängen vor dem Tablet. Meine erste Reaktion war darüber einfach nur den Kopf zu schütteln. Mein Gedanke: Typisch iPad-Kinder.

“Das ‘iPad Kind’ ist ein Begriff, der sich auf ein Kind bezieht, das seine gesamte Unterhaltung über ein iPad (oder eine andere Art von Technologie) bezieht und sich so von der Welt um sich herum abkapselt.”

Victoria Purchase, Penn State University

Was aber auf den ersten Blick harmlos erscheint, umschreibt den eigentlich problematischen, nicht kontrollierten bzw. überwachten Gebrauch von mobilen Endgeräten. 81% der Kinder unter 11 Jahren konsumieren regelmäßig Youtube, 34 % davon sogar regelmäßig. Das zeigt eine Studie des Pew Research Centers. Es bleibt also nicht bei Lernspielen auf mobilen Endgeräten, sondern Kinder werden auch mit Sozialen Medien – in diesem Falle YouTube – konfrontiert. (Zu fragen, ob das überhaupt richtig ist und ab wann Kinder sich mit den Sozialen Medien auseinandersetzen sollten, würde ein Fass ohne Boden öffnen – ich habe keine Intentionen, Fragen zu stellen, auf die ich keine Antwort weiß.) Aber ist YouTube denn schlimm?

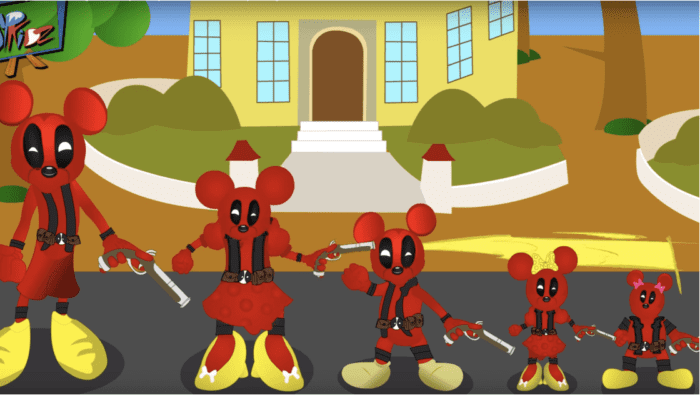

Peppa Pig geht zum Zahnarzt und kriegt dort unter lautem Weinen und Schreien sämtliche Zähne gezogen. Ein vermeintlich ‚kinderfreundliches‘ Video mit verstörendem Content ist zu leicht an Kinder gelangt. Dieses Video ist leider kein Einzelfall: In Videos des Kanals Superkidz Finger Family schießen sich Mickey Mouse-ähnliche Figuren erst gegenseitig – und anschließend selbst – in den Kopf. Die Liste geht weiter: Peppa Pig, die Bleichmittel trinkt. Paw Patrol Charaktere, die sterben und beerdigt werden. Peppa Pig Figuren, die ‚böse‘ Figuren jagen und aus Flugzeugen werfen. Peppa Pig verkleidet als Elsa, die von einer ‚bösen‘ Elsa attackiert wird. Die letzten beiden Videos stammen sogar von einem offiziellen YouTube Kanal mit knapp 190.000 Abonnent*innen. “Wenn man nicht genau hinschaut, könnte es wie ein gewöhnliches Video mit Peppa Pig aussehen”, so ein BBC Trending Artikel von 2017. Und genau dort liegt das Problem: Kinder, die ohne elterliche Aufsicht derartigen Videos ausgesetzt sind, können nicht unterscheiden zwischen harmlosen und verstörenden Inhalten.

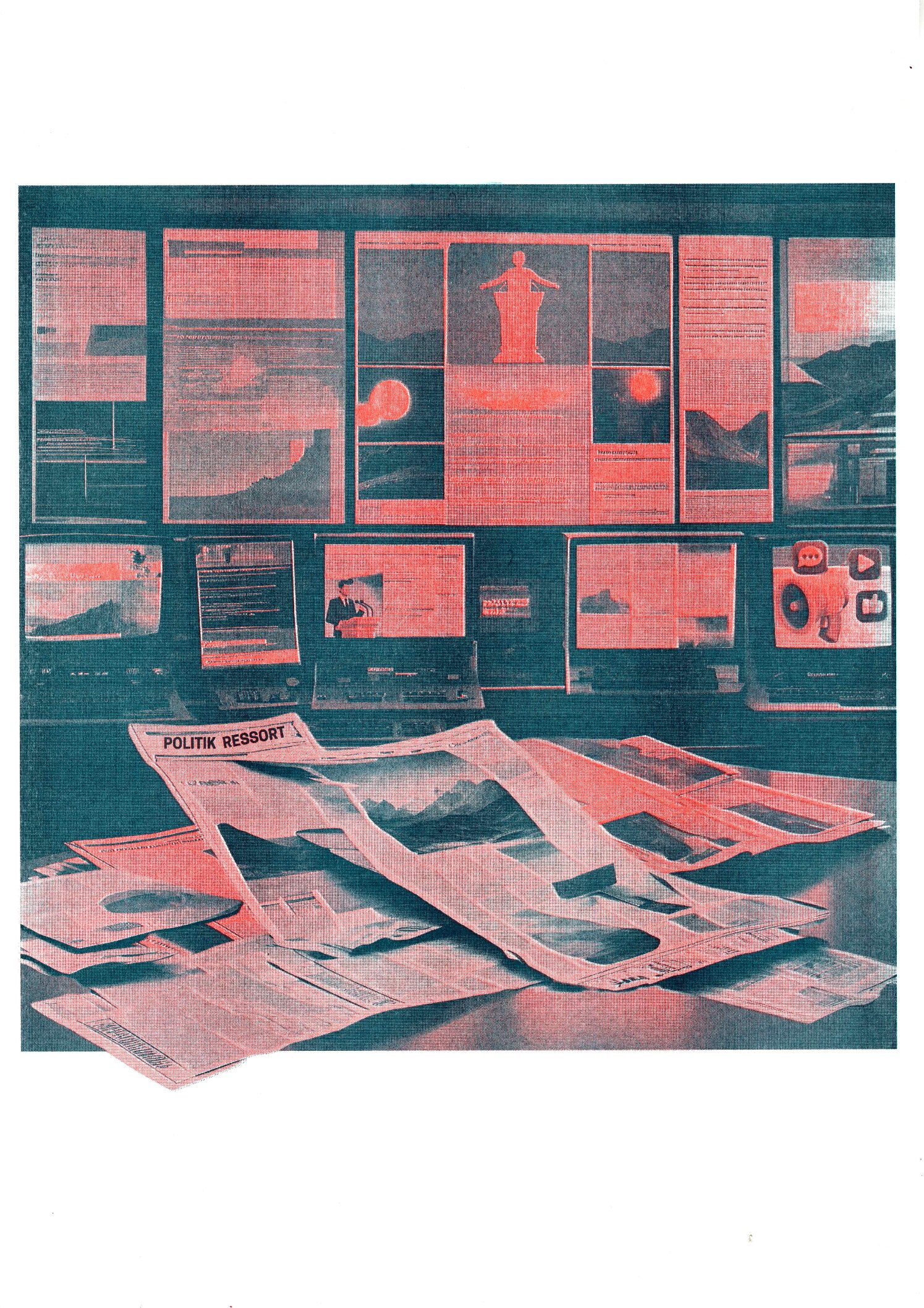

Elsagate. Der Neologismus spricht von ebendiesen nicht-kinderfreundlichen Inhalten auf kinder- und familienfreundlichen Plattformen wie YouTube und YouTube Kids. Meistens handelt es sich um ein Crossover von kinderfreundlichen Charakteren und verstörenden Inhalten; aus dem Kontext gerissen und grotesk verzerrt halten die Gesichter von bekannten Comic- oder Disneycharakteren in Videos mit gewaltvollen, sexualisierten, fetischisierten, mit Drogen, Alkohol oder Nacktheit versetzten Inhalten für Thumbnails her. Typisch für Elsagate-Content bzw. diese Art von Videos sind Hintergrundmusik und Soundeffekte, jedoch keine Dialoge – vermutlich, um damit Zuschauer*innenkreise nicht einzuschränken.

„Es gibt Hunderte dieser Videos auf YouTube, und einige werden millionenfach aufgerufen”, erklärt ein BBC Trending Artikel von 2017. Eine derart hohe Anzahl an Aufrufen kann nur dann zustande kommen, wenn der Konsum des Kindes nicht von Erziehungsberechtigen überwacht wird oder wenn der Content von Erwachsenen konsumiert wird, die das Video nicht melden. Doch wie kommt es eigentlich zu solchen Videos? Autor und Kritiker der digitaltechnologischen Zukunft James Bridle bezeichnet sie in einem The Guardian-Artikel von 2018 als “ körnige Animationen von einer Bot-Farm in China”. Obwohl diese Vermutung nahe liegt, gibt es hierfür jedoch keine eindeutigen Beweise. Manchmal wird diese Art von Content auch von als Charakteren verkleideten Erwachsenen produziert. Eine Sache steht jedoch fest: Es werden vorzugsweise die Themen produziert, die Algorithmen bei Zuschauer*innen als ‚beliebt‘ einstufen. Laut Bridle kommt es deshalb bei diesen Videos zu so vielen Aufrufen: „Der scheinbar harmlose Mechanismus ‘Wenn du das magst, wirst du auch das mögen’ führt im Wesentlichen dazu, dass kleine Kinder – praktisch von Geburt an – dazu erzogen werden, auf das erste Angebot zu klicken, das sie sehen, unabhängig von der Quelle.“ Sprich, wenn Kinder Peppa Pig mögen, bekommen sie diese Art von Video früher oder später angezeigt, Kinder klicken darauf und sagen dem Algorithmus damit: Du hattest Recht mit deiner Einschätzung. Bitte mehr davon!

Die naheliegendste Reaktion auf solche Ereignisse sind – natürlich – Regulierungen. Ein derart hoher Anteil von Kindern, die unter dem von YouTube vorgeschriebenem Nutzungsalter von 13 Jahren liegt, bringt eine ‚Regulierung‘ mit sich, die auf den ersten Blick plausibel wirkt: Die YouTube Kids App. Denn während Google selbst für YouTube ein Mindestalter von 13 Jahren angibt, wird für die YouTube Kids App kein Mindestalter vorgegeben. Laut der YouTube Kids App könnten „Kinder in einer sichereren Umgebung eigenständig eine Vielzahl von Videos entdecken. Dabei behalten Eltern den Überblick darüber, wie ihre Kinder die App nutzen.“ Eltern können unter drei Filtern auswählen: Kinder bis einschließlich vier Jahre, fünf bis acht und neun bis zwölf. Doch trotz der automatisierten Filter und manuellen Überprüfungen der Videoinhalte schaffen es immer noch Videos mit verstörenden Inhalten auf die ‚kindersichere‘ Plattform.

Wie ist das möglich? „Kein Filter ist 100 % zuverlässig[…]“, lässt Google über die YouTube Kids App verlautbaren. Tatsächlich beinhalten 27 % der Videos, konsumiert von Kindern unter acht Jahren, Inhalte, die auf ältere Zuschauer*innen ausgerichtet sind – meistens seien diese Inhalte gewaltvoll, so Caroline Knorr, Erziehungsexpertin bei der Nonprofit-Organisation Common Sense. Bei der Einrichtung der App stellt YouTube Kids Eltern vor die Wahl: Sie können sich entweder auf den Filter verlassen, oder aber Kindern wird nur Zugriff auf die von Eltern handverlesenen Videos erlaubt. Das würde bedeuten, dass sich Eltern jedes einzelne Video ansehen und für ihre Kinder entweder freischalten oder sperren. Allerdings stellt Google mit dem Filter lediglich eine Option für behelfsmäßige Sicherheitsmaßnahmen zur Verfügung, die mit Vorsicht zu genießen sei. Denn Google setzt darauf, dass Eltern den Videokonsum ihrer Kinder ständig überwachen und für den geschauten Inhalt verantwortlich sind: “Wir arbeiten hart daran, Inhalte auszuschließen, die nicht für Kinder geeignet sind. Aber wir können nicht alle Videos manuell überprüfen und kein automatisches System ist perfekt. Wenn Sie etwas Unangemessenes finden, können Sie es blockieren oder zur schnellen Überprüfung melden.” Bei der Frage nach Verantwortung fühlt sich niemand angesprochen. Eltern verweisen auf die Fahrlässigkeit der schludrigen Filter von Multi-Milliarden-US Dollar-Unternehmen, Google verweist auf die naive Technik-Hörigkeit von Erziehungsberechtigten.

Es soll sich die Tür zu einer Diskussion öffnen: Dürfen Unternehmen wie Google überhaupt dazu berechtigt werden, YouTube Kids als „kinder- und familienfreundlich“ zu deklarieren und die Plattform ohne Warnhinweise und ohne Mindestalter zur Verfügung zu stellen, wenn sie die psychische Sicherheit von Kindern nicht garantieren können? Dürfen Eltern dazu in der Lage sein, die Verantwortung an fremde Unternehmen zu übertragen und diese möglicherweise im schlimmsten Falle sogar zur Rechenschaft zu ziehen, wenn die Nutzung durch eines ihrer Produkte die Sicherheit ihrer Kinder nicht gewährleisten kann, weil sie darauf vertraut haben?